Regularización de algoritmos: mejora tus modelos de predicción

La predicción es un tema importante en el mundo de los negocios y la tecnología. La capacidad de predecir el comportamiento futuro de los clientes, los mercados y los sistemas es una herramienta valiosa para cualquier empresa. Sin embargo, la precisión de las predicciones depende en gran medida de la calidad de los modelos de predicción utilizados. Los modelos de predicción se construyen utilizando algoritmos, y estos algoritmos pueden ser mejorados mediante la regularización.

La regularización es una técnica de aprendizaje automático que se utiliza para reducir el sobreajuste de los modelos de predicción. El sobreajuste es un problema común en los modelos de predicción, en el que los modelos se ajustan demasiado a los datos de entrenamiento y pierden la capacidad de generalizar a nuevos datos. La regularización ayuda a reducir este problema al penalizar los coeficientes de los modelos que son demasiado grandes.

Existen dos tipos principales de regularización: la regularización L1 y la regularización L2. La regularización L1, también conocida como regularización de Lasso, penaliza los coeficientes de los modelos que son demasiado grandes al forzarlos a ser cero. Esto tiene el efecto de eliminar características irrelevantes del modelo y reducir la complejidad del modelo.

La regularización L2, también conocida como regularización de Ridge, penaliza los coeficientes de los modelos que son demasiado grandes al forzarlos a ser cercanos a cero. Esto tiene el efecto de reducir la magnitud de los coeficientes y reducir la complejidad del modelo.

Ambas técnicas de regularización son útiles para reducir el sobreajuste de los modelos de predicción. La elección de la técnica de regularización depende del problema específico que se está abordando y de la naturaleza de los datos.

Cómo funciona la regularización

La regularización funciona al agregar un término de penalización a la función de costo utilizada para entrenar los modelos de predicción. Este término de penalización se basa en la magnitud de los coeficientes del modelo. Cuanto más grandes sean los coeficientes, mayor será la penalización.

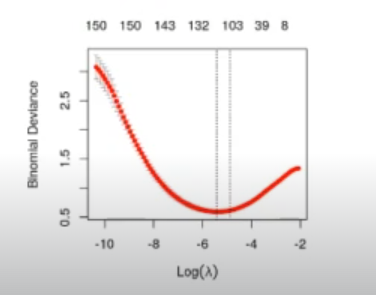

La penalización puede ser controlada mediante un parámetro llamado parámetro de regularización. Este parámetro controla la importancia de la penalización en relación con la función de costo. Un valor alto del parámetro de regularización dará como resultado una mayor penalización y, por lo tanto, un modelo más simplificado. Un valor bajo del parámetro de regularización dará como resultado una menor penalización y, por lo tanto, un modelo más complejo.

Ventajas de la regularización

La regularización tiene varias ventajas importantes en el mundo de los modelos de predicción. Algunas de estas ventajas incluyen:

1. Reducción del sobreajuste

La regularización reduce el sobreajuste de los modelos de predicción, lo que significa que los modelos son más precisos en la predicción de nuevos datos.

2. Mejora de la generalización

Al reducir el sobreajuste, la regularización mejora la capacidad de los modelos de predicción para generalizar a nuevos datos y situaciones.

3. Eliminación de características irrelevantes

La regularización puede eliminar características irrelevantes del modelo, lo que reduce la complejidad del modelo y mejora su precisión.

4. Reducción de la complejidad

La regularización reduce la complejidad de los modelos de predicción, lo que hace que sean más fáciles de entender e interpretar.

Desventajas de la regularización

Aunque la regularización tiene muchas ventajas, también tiene algunas desventajas importantes que deben tenerse en cuenta. Algunas de estas desventajas incluyen:

1. Pérdida de información

La regularización puede eliminar características importantes del modelo junto con las irrelevantes, lo que puede resultar en una pérdida de información importante.

2. Necesidad de ajustar el parámetro de regularización

La elección del valor adecuado del parámetro de regularización puede ser difícil y requiere una comprensión profunda del problema específico y los datos.

3. Aumento del tiempo de entrenamiento

La regularización puede aumentar el tiempo de entrenamiento necesario para construir modelos de predicción, lo que puede ser un problema en situaciones en las que el tiempo es importante.

Cuándo utilizar la regularización

La regularización es una técnica útil en situaciones en las que se espera que los modelos de predicción se ajusten demasiado a los datos de entrenamiento. Esto puede ser especialmente útil en situaciones en las que se espera que los datos de prueba sean diferentes de los datos de entrenamiento, como en el aprendizaje automático de transferencia.

La elección de la técnica de regularización adecuada depende del problema específico y los datos. En general, la regularización L1 es más adecuada cuando se espera que el modelo tenga características irrelevantes, mientras que la regularización L2 es más adecuada para problemas en los que se espera que todas las características sean importantes.

Cómo implementar la regularización

La regularización se puede implementar en una variedad de algoritmos de aprendizaje automático, incluidos los árboles de decisión, la regresión logística y las redes neuronales. En general, la regularización se implementa a través de la inclusión de un término de penalización en la función de costo utilizada para entrenar el modelo.

El parámetro de regularización se puede ajustar utilizando técnicas de validación cruzada, que implican la división de los datos en conjuntos de entrenamiento y prueba y la evaluación del rendimiento del modelo en los datos de prueba. El valor del parámetro de regularización que da como resultado el mejor rendimiento en los datos de prueba se selecciona como el valor óptimo del parámetro de regularización.

Conclusión

La regularización es una técnica importante en el mundo de los modelos de predicción. La capacidad de reducir el sobreajuste y mejorar la generalización de los modelos de predicción puede llevar a una mayor precisión y confiabilidad en las predicciones. Aunque la elección de la técnica de regularización adecuada y el ajuste del parámetro de regularización pueden ser desafiantes, la implementación adecuada de la regularización puede mejorar significativamente los modelos de predicción.

Preguntas frecuentes

1. ¿Qué es el sobreajuste?

El sobreajuste es un problema común en los modelos de predicción en el que el modelo se ajusta demasiado a los datos de entrenamiento y pierde la capacidad de generalizar a nuevos datos.

2. ¿Qué es la regularización L1?

La regularización L1, también conocida como regularización de Lasso, penaliza los coeficientes de los modelos que son demasiado grandes al forzarlos a ser cero. Esto tiene el efecto de eliminar características irrelevantes del modelo y reducir la complejidad del modelo.

3. ¿Qué es la regularización L2?

La regularización L2, también conocida como regularización de Ridge, penaliza los coeficientes de los modelos que son demasiado grandes al forzarlos a ser cercanos a cero. Esto tiene

Deja una respuesta